[Day 28] Convolutional Neural Networks 더 깊게 잠수하기

안녕하세요!

오늘은 Day 28입니다!

오늘은 CNN 지식을 넓히려고 했다

오늘의 내용이 좀 어려우면서도 재미있었다

CNN 기초 지식, 널리 사용하는 CNN 아키텍처 ( LeNet, AlexNet, VGG-16, ResNet, MobileNets)에 대해 공부했다

1. 기초 지식

conv layer 어떻게 되는지 다시 공부했다

filter 파라미터에 따라 다양한 피처에 대해 알 수 있다

이 사진을 보시면 conv 레이어, pool 레이어로 모델을 구성했다.

pool 레이어 중 average, max 레이어가 있고 계산도 다르다.

좋은 아키텍처를 알고 싶으면 논문을 읽어서 알 수도 있다

2. 널리 사용하는 CNN 모델

LeNet

AlexNet

VGG-16

ResNet

ResNet의 'skip connections'으로 많이 깊은 딥러닝 신경망 모델 훈련하게 했다. ResNet 더 알아보기 위해 kaggle에서 직접 사용해 봐야 한다! ~ 중요한 것 같다

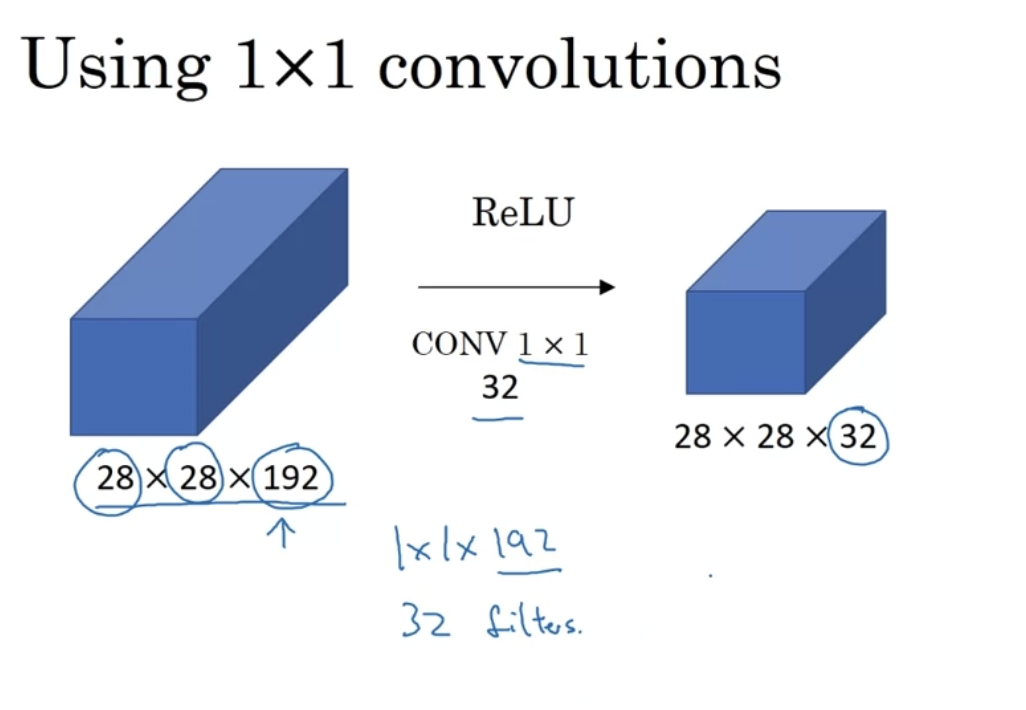

1x1 convolutions

마지막으로,

MobileNets

normal conv으로 하면, 비용이 2160인데 Mobile net으로 하면 비용이 672이다

'normal convolution'의 과정이 복잡하고 계산적으로 비용이 많이 드는 것이다.

오늘의 내용을 좀 더 이해하려면 kaggle에서 이런 모델을 사용하는 notebook 읽을 것이다

오늘은 여기까지입니다!

내일 뵐게요!