[Day 25] Andrej Karpathy 교수님이 천재다!

안녕하세요!

오늘은 Day 25입니다!

- 우연히 Andrej Karpathy의 신경망에 대한 유튜브 시리즈 찾게 되고 한번 보자고 했다

8가지 영상을 포함한다

보시다시피 오늘 4번 전반까지 봤다. 꽤 재미있었다오늘 본 내용을 요약하자면

첫 번째, forward 및 back propagation 지식을 넓혔다. Karpathy 교수님에 덕분이다.

간단한 이미지인데도

forward prop은 prediction 찿는 거고

손실을 계산한 뒤에 back propagation은 calculus의 chain rule로 각 neuron의 gradient 계산한다

그 다음에 SGD, Adam 등으로 optimisation 한다

그 다음에, 단순 character text prediction 모델 구성하셨고 DeepLearning.AI의 text generation course와 비슷하다.

그런데 ~

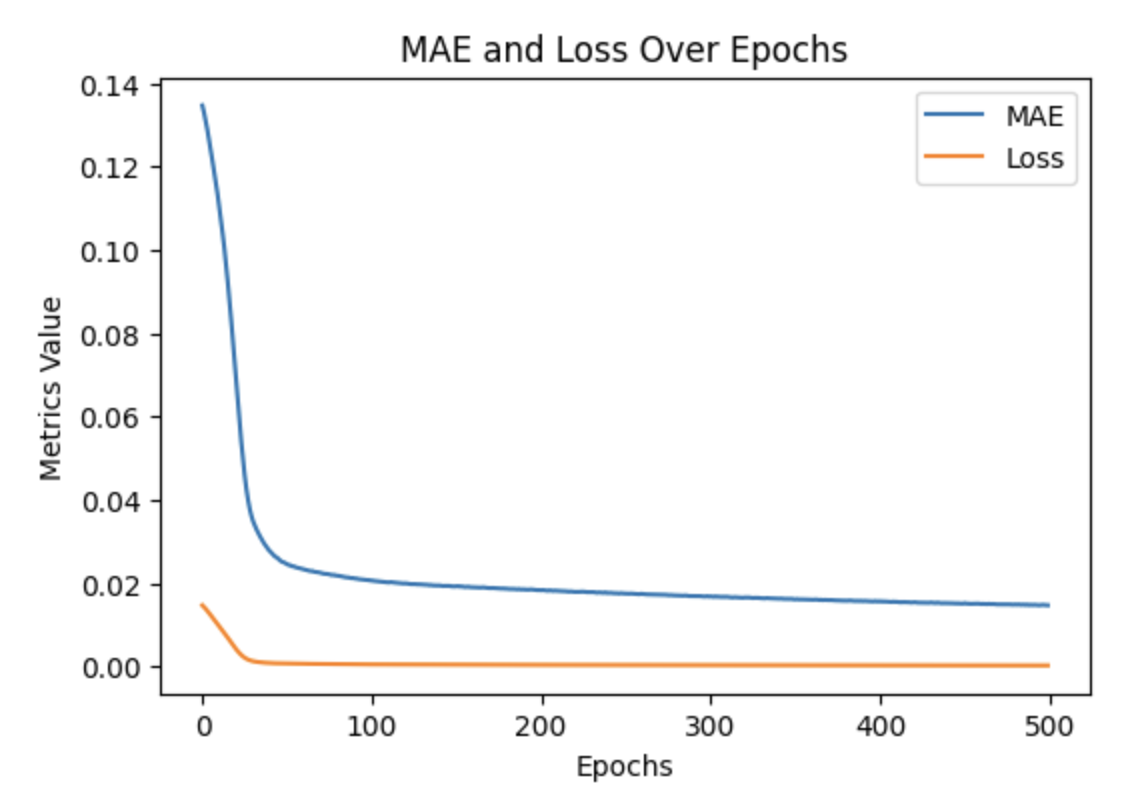

4번째 영상에서 신경망 모델의 손실 함수 내용이 나왔다. 손실 시각화는 hockey-stick와 비슷하면 안 된다고 하셨다 (좋지 않은 편이라고 하셨다). 어제 했던 모델의 손실이 그랬다고 생각이 난다. (다음과 같다)

그래서, 모델 구조 다시 변경해 봤다

이런 경우에 마지막 레이어의 bias 직접 넣어 두면 좋은 해결 방법인 편이라고 하셨다.

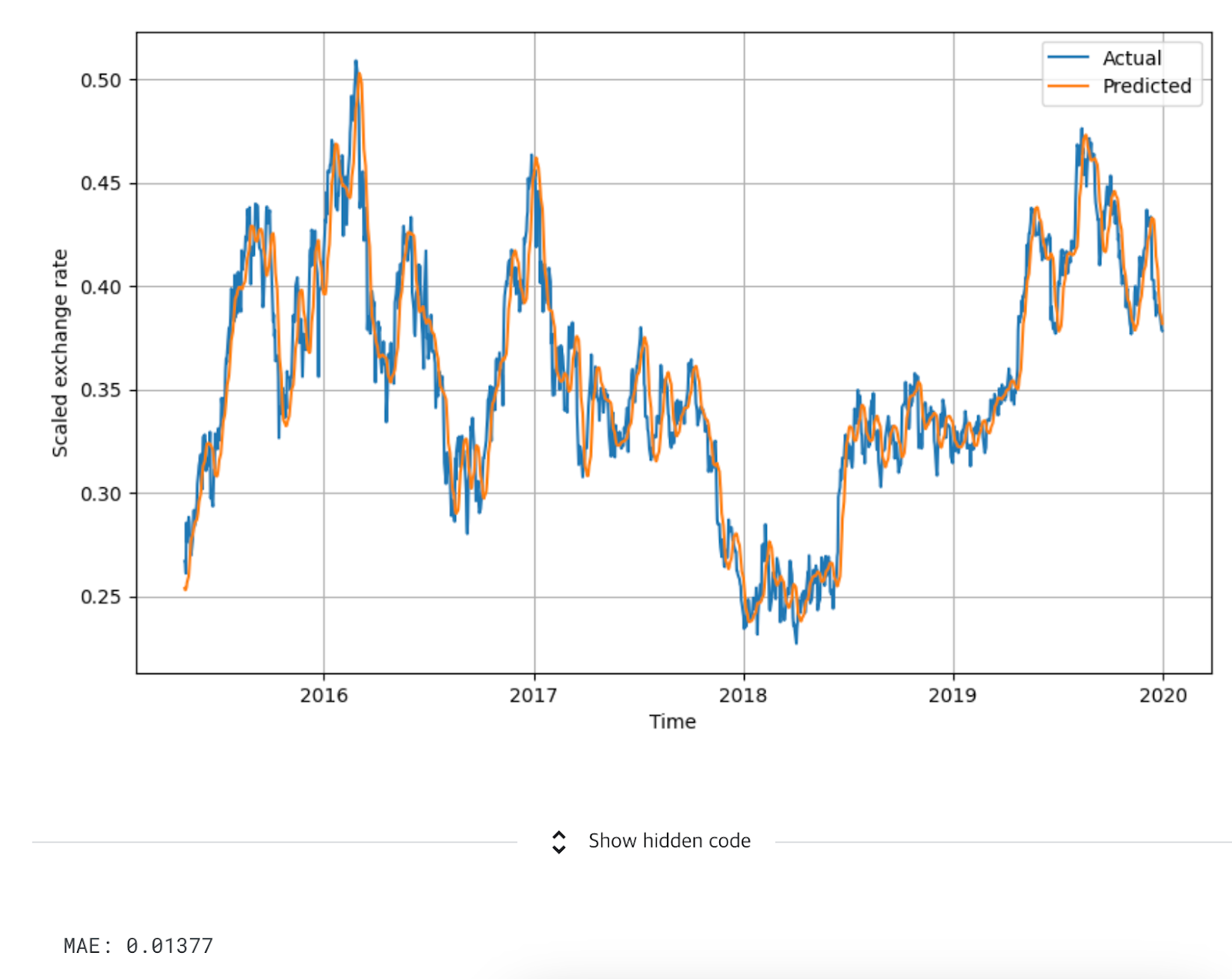

이거 바꾼 후에 모델 구조도 변경해 보고 결과는 다음과 같다

아직도 hockey-stick 모양이 나오는데 이전보다 좋은 것 같다.

4번째 강의를 다시 봐야겠다

내일 계속 Andrej Karpathy의 강의를 공부할 것이다

오늘은 여기까지입니다!

내일 뵐게요!